新的研究发现,AI技术尚未足够先进,无法诊断复杂的医学问题。

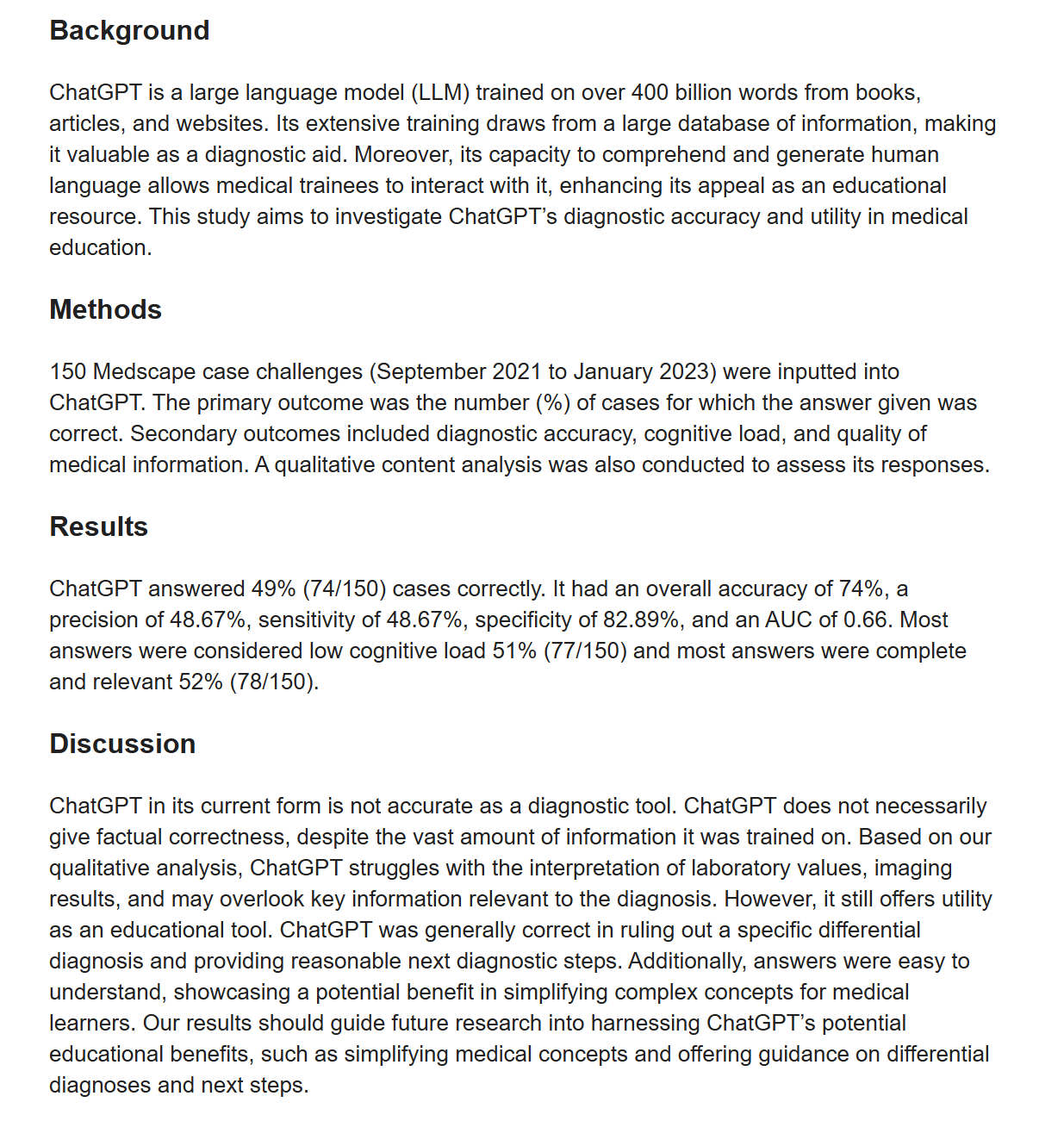

根据发表在《PLOS One》期刊上的一项新研究,AI不应被用于医学诊断。由西伦敦大学进行的这项研究发现,当面对一系列医学问题时,ChatGPT的诊断正确率不到一半。

研究人员要求ChatGPT从多种选项中选择正确的诊断,并提供选择的解释。结果显示,ChatGPT的诊断正确率仅为49%,尽管它在简化复杂医学术语方面表现良好。

在医疗领域的快速发展中,研究人员热衷于探索这项快速增长技术的潜在用例,但这些研究结果表明,机器人短期内还不会在医院病房中进行巡查。

AI 尚未为医疗做好准备

研究人员向 ChatGPT 提出了 150 个复杂的医学案例,并要求它从多项选择题中提供正确的诊断,并解释其选择理由。研究团队发现,尽管 ChatGPT 给出了简洁且听起来令人信服的答案,但它的正确率只有 49%。

根据 CBC 报道,这项于 7 月发表的研究旨在评估 ChatGPT 在医学教育中的“诊断准确性和实用性”。首席研究员阿姆里特·科帕拉尼博士表示:“我们想知道,它会如何处理我们在医学中遇到的这些复杂病例?”

尽管这一准确率无助于缓解有关错误信息的争论,但研究人员对该平台简化复杂医学术语的能力感到鼓舞。科帕拉尼补充道:“我认为我们可以将其用于教育。”

研究人员探索潜在用例

这些发现为AI在医疗行业的应用提供了新的视角。研究人员决心在医疗领域为AI找到合适的应用用例。斯坦福大学的一项研究最近评估了大语言模型(LLM)是否可以用于诊断强迫症,这是一种 notoriously 难以识别的疾病。

令人惊讶的是,AI 在几个实例中优于医疗专业人员。ChatGPT-4 在所有被提供的案例中正确识别了强迫症。相比之下,心理学博士生只能在 81.5% 的情况下诊断出强迫症,而初级保健医生的诊断正确率仅为 49.5%。

西伦敦大学的研究最初于 2023 年使用 ChatGPT 和 ChatGPT-3.5 LLM 进行。在斯坦福大学的研究结果下,科学家们只能推测更新模型在面对同样的诊断挑战时表现如何。

AI 仍然存在争议

尽管这项技术正在以惊人的速度发展,AI 依然在公众中引发了分歧。其最大的支持者——如埃隆·马斯克和马克·扎克伯格等科技巨头——认为我们正处于全球革命的边缘。

然而,根据皮尤研究中心的数据,超过一半的美国公民(52%)对 AI 的潜力“更感到担忧而非兴奋”。进一步调查显示,60% 的人对他们的医疗从业人员依赖 AI 感到不安。

近年来,随着AI在一系列引人注目的错误事件中的中心地位,关于错误信息传播的担忧有所增加。例如,今年早些时候,谷歌的 Gemini 项目因被马斯克批评为“种族主义”和“反文明”而引发关注。

虽然这些发现为AI在医学领域的未来提供了希望,但它们也提醒我们保持警惕——医疗行业和更广泛的公众在面对AI时,仍应保持适当的怀疑态度。

参考资料:

https://tech.co/news/chatgpt-medical-diagnosis-wrong